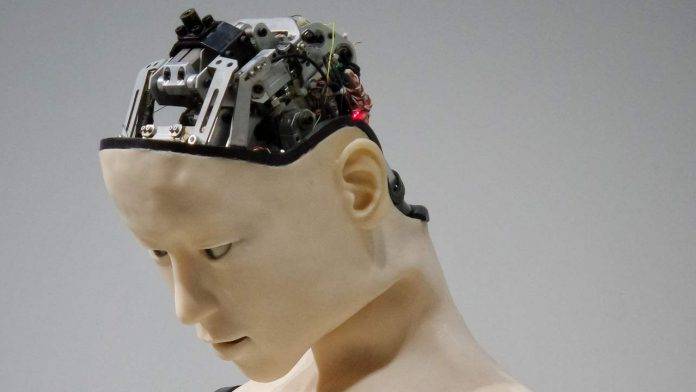

E’ stato approvato l’AiAct, ossia l’insieme delle norme che il Parlamento europeo ha varato per regolare l’intelligenza artidiciale.

Il Parlamento eueopeo approva l’AiAct

Via libera dall’Eurocamera all’AiAct, il testo che racchiude le nuove regole Ue per l’Intelligenza artificiale. L’aula di Strasburgo ha approvato con 499 voti a favore 28 contrari e 93 astenuti la prima regolamentazione al mondo pensata per imprimere alle tecnologie come Chat Gpt il rispetto delle leggi Ue e dei valori fondamentali e per combattere la discriminazione digitale e prevenire la disinformazione e l’utilizzo dei “deep fakes”. Il voto apre la strada ai triloghi con i Paesi membri e la Commissione Ue, il primo negoziato è previsto già per questa sera. L’europarlamento ha poi sostenuto il divieto totale di utilizzo di tecnologie di riconoscimento biometrico ad intelligenza artificiale in tempo reale nei luoghi pubblici. E’ stato bocciato l’emendamento del Ppe che chiedeva di inserire nell’AiAct alcune eccezioni per permettere l’uso di telecamere riconoscimento facciale nelle strade e ai confine dell’Ue per motivi di sicurezza nazionale o nei casi di minori scomparsi.

L’approccio che seguono le norme

Le norme seguono un approccio basato sul rischio e stabiliscono obblighi per fornitori e operatori dei sistemi di IA a seconda del livello di rischio che può generare. Saranno quindi vietati i sistemi di IA che presentano un livello di rischio inaccettabile per la sicurezza delle persone, come quelli utilizzati per il punteggio sociale (classificare le persone in base al loro comportamento sociale o alle loro caratteristiche personali). I deputati, rispetto al testo iniziale, hanno ampliato l’elenco per includere divieti sugli usi intrusivi e discriminatori dell’IA, come: l’uso di sistemi di identificazione biometrica remota “in tempo reale” e “a posteriori” in spazi accessibili al pubblico; i sistemi di categorizzazione biometrica basati su caratteristiche sensibili (ad esempio genere, razza, etnia, cittadinanza, religione, orientamento politico); i sistemi di polizia predittiva (basati su profilazione, ubicazione o comportamenti criminali passati); i sistemi di riconoscimento delle emozioni utilizzati dalle forze dell’ordine, nella gestione delle frontiere, nel luogo di lavoro e negli istituti d’istruzione; e l’estrazione non mirata di dati biometrici da Internet o da filmati di telecamere a circuito chiuso per creare database di riconoscimento facciale (in violazione dei diritti umani e del diritto alla privacy).

Cosa prevede il testo approvato dal Pe

Il testo approvato dal Pe prevede che la classificazione delle applicazioni ad alto rischio includa anche i sistemi di IA che comportano danni significativi per la salute, la sicurezza, i diritti fondamentali delle persone o l’ambiente. Sono stati aggiunti alla lista ad alto rischio i sistemi di intelligenza artificiale utilizzati per influenzare gli elettori e l’esito delle elezioni e i sistemi di raccomandazione utilizzati dalle piattaforme di social media (con oltre 45 milioni di utenti). I sistemi di IA generativa che si basano su tali modelli, quali ChatGPT, secondo il testo, dovrebbero rispettare i requisiti di trasparenza (dichiarando che il contenuto è stato generato dall’IA), aiutando anche a distinguere le cosiddette immagini deep-fake e da quelle reali, e fornire salvaguardie per evitare la generazione di contenuti illegali. Dovrebbero inoltre essere pubblicate le sintesi dettagliate dei dati protetti dal diritto d’autore utilizzati per l’addestramento.

Fonte Ansa